En la economía digital actual, los datos son el alma de las operaciones empresariales. La extracción de datos es fundamental para aprovechar los datos adecuados para impulsar la inteligencia empresarial y el análisis con el fin de obtener información valiosa sobre los clientes, las tendencias del mercado y las operaciones de la empresa. Y el mercado del comercio electrónico es muy competitivo. Sólo Amazon cuenta con más de 2 millones de vendedores y un gran número de listados de productos que se actualizan a diario. Muchas organizaciones optan por el web scraping para obtener datos.

Sin embargo, diversos factores pueden hacer que el proceso de extracción de datos resulte complejo, lento y difícil. Comprender estos desafíos e implementar una solución de extracción de datos adecuada puede garantizar que su enfoque sea eficiente, preciso y seguro.

En este post, hablaremos de 3 retos clave, y obtendrá una comprensión fundamental de lo que es la extracción de datos y cómo puede superarlos para lograr un rendimiento empresarial más inteligente.

¿Qué es Extracción de datos?

La extracción de datos de la red es la práctica de copiar datos por robots a gran escala. Tiene muchos nombres dependiendo de cómo se denomine, como manipulación de redes, manipulación de datos, manipulación web, etc.

Normalmente, la mayoría de los datos están dispersos en varios canales diferentes, como datos de gestión de relaciones con los clientes, datos financieros, hojas de cálculo, PDF, documentos, archivos, imágenes, etc. Aquí es donde entra en juego el proceso de extracción de datos. Se trata de recopilar e integrar todos estos datos y almacenar la información recopilada en un formato específico para su uso posterior.

Las empresas de todo el mundo almacenan los datos extraídos en bases de datos y luego los integran con herramientas de inteligencia empresarial y análisis para obtener información significativa. De este modo, se reconocen patrones y tendencias, se comprenden los cambios en el mercado y se toman rápidamente medidas basadas en los conocimientos descubiertos a partir de los datos extraídos.

Ver más: Extracción de Datos de Web: La Guía Definitiva

Los desafios para extraer Datos de Comercio Electronico Web

Gran problema 1: Extracción a gran escala

Para los propietarios de tiendas de comercio electrónico, administre más de 20 subcategorías en una categoría principal todos los días Estos suman un total de más de cien artículos. No parece realista copiar y pegar la información de cada producto, incluida la SKU, la imagen en miniatura, la descripción, el envío y las reseñas de los clientes en una sola hoja de cálculo para registros y análisis a diario. El trabajo monótono no solo toma su tiempo sino que también conduce a una menor calidad y precisión de los datos.

¿Outsourcing o equipo interno?

En la mayoría de los casos, los propietarios optarían por la subcontratación o un equipo interno para construir un rastreador web para ellos. Tenga en cuenta que todos los sitios web son versátiles y varían en estructuras. Existe una gran posibilidad de que necesite ajustar el rastreador de vez en cuando. El servicio y mantenimiento son un gasto considerable cada año. Además, si el proveedor no es confiable, dejará los datos inseguros.

Una herramienta de web scraping es una gran alternativa

Una herramienta intuitiva de web scraping como Octoparse lo ayudaría a lograr un mejor resultado a un costo menor. El web scraping ya no es el privilegio de un programador y no debería costarle demasiado.

- Simplicidad: Puede crear un rastreador con simples clics y arrastrar y soltar. Lo mejor de todo, no requiere habilidades profesionales.

- Seguridad: Octoparse permite el trabajo colaborativo. Usted tiene control sobre la fuente de datos y la calidad de los datos. Los datos extraídos solo se manejarán en manos de agentes de confianza.

- Menor costo: minimiza el costo de mantenimiento, ya que puede depurar el flujo usted mismo en unos pocos clics. En comparación con un servicio de terceros, una herramienta de raspado web reduce el costo por datos y aumenta el margen bruto.

A continuación, le mostramos cómo puede aprovechar Octoparse para resolver el problema y mejorar su negocio en unos pocos pasos:

- Descargue e instale Octoparse en su computadora local

- Elija una plantilla de web scraping en la categoría Producto.

- Completa los parámetros.

- Ejecute la tarea en su dispositivo local o en una nube.

- Exporte los datos a un formato de archivo de su elección, p. ej hoja de cálculo o base de datos.

Al conectarse con su base de datos a través de la API, puede actualizar su base de datos automáticamente. Como tal, puede monitorear la mayoría de los principales sitios web de comercio electrónico como eBay, Flipkart, Target y BestBuy al mismo tiempo.

Más Herramientas de Web scraping: 30 Mejores Softwares Gratuitos de Web Scraping

Gran problema 2: Obtener una lista negra/bloqueada

Otro desafío importante para muchas personas es ser bloqueado por sitios web. Hay muchas razones que pueden desencadenar un acto defensivo de este tipo, y la más común se debe a la anormalidad de la dirección IP.

Por ejemplo, cuando solicita demasiados recursos en una ventana de tiempo determinada, el servidor pensará que el usuario no es una persona real. Para evitar abusos, el servidor pone en la lista negra su dirección IP. Una dirección IP es su identidad para comunicarse en Internet con un recurso en línea.

Para evitar ser incluido en la lista negra, un scraper deberá actuar como un humano. ¿Qué hace que un bot sea diferente a un ser humano frente a una computadora? Como un rastreador está programado, su comportamiento sigue un cierto patrón. Sin embargo, las interacciones de los humanos con Internet son impredecibles. Necesitamos romper los patrones haciendo algunos actos aleatorios.

Hay tres cosas que puedes hacer:

- Disminuya la velocidad de su scraping: Los humanos no pueden navegar a velocidades extremadamente rápidas, pero los robots lo harán.

- Cambiar de agente de usuario: Un agente de usuario indica con qué navegador está interactuando el sitio web. Revelamos la identidad robot si se envían solicitudes consistentes con el mismo agente de usuario. Octoparse proporciona una lista de agentes de usuario que permite que el rastreador cambie dentro de un cierto intervalo de tiempo.

- Girar dirección IP: Asigne solicitudes a diferentes direcciones IP para que sea más difícil para los servidores detectar una anomalía. La rotación de IP es el método más efectivo para mantener el scraping de la web sin interrupciones. Hay muchos proveedores de Proxy IP que pueden cambiar su dirección IP. Sin embargo, la calidad de las redes varía

Solución de rotación de IP:

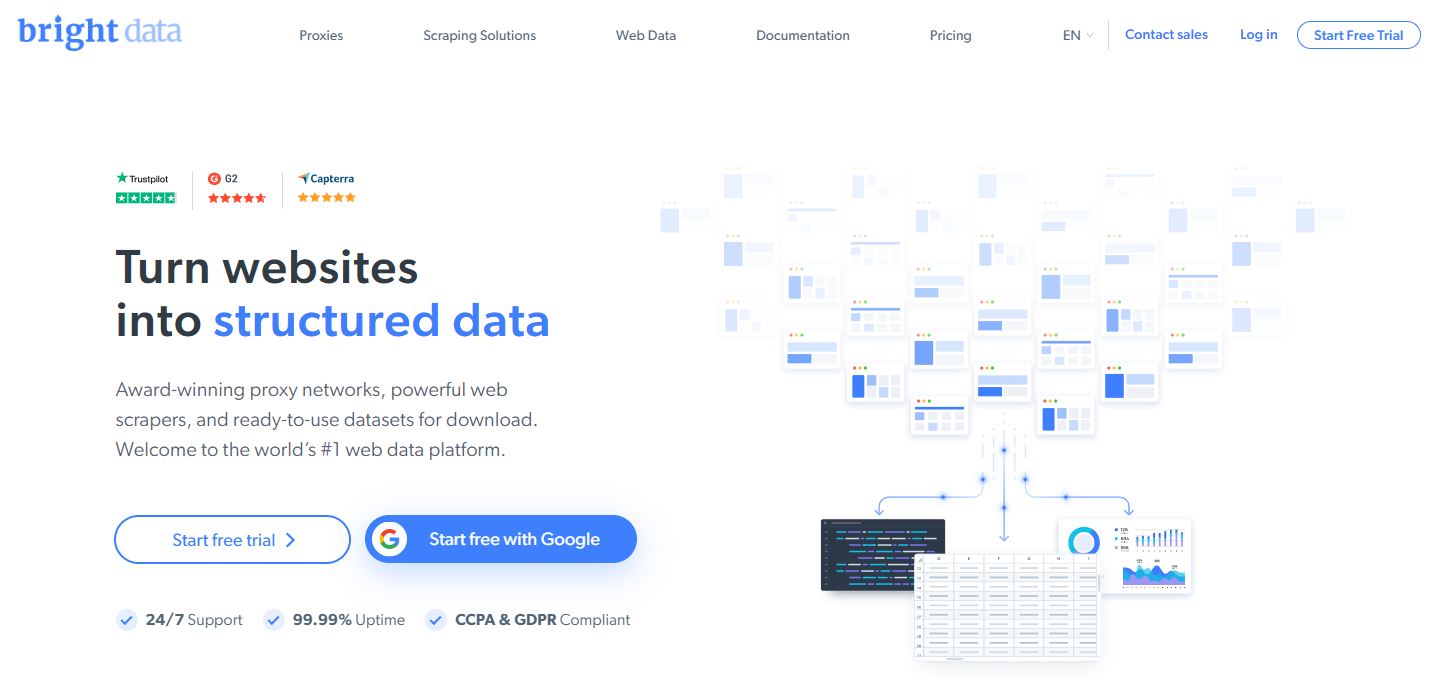

Brightdata lidera el mercado con la red de proxy residencial más grande del mundo. Proporcionan 4 tipos de redes:

- Agente de rotación de direcciones: puede intercambiar IP de usuarios reales de ciudad a ciudad en todo el mundo. Es extremadamente útil para recopilar información sobre análisis de mercado y comparación de precios.

- Red de proxy móvil: imita a usuarios móviles reales, lo que le permite trabajar en una campaña de marketing en plataformas de redes sociales centradas en dispositivos móviles.

- Proxies residenciales estáticos: simulan IP residenciales reales sin rotación de IP, lo que garantiza la finalización ininterrumpida de la tarea.

- Proxies del centro de datos: esto le permite compartir proxies, lo que es útil cuando se necesita un scraping masivo.

Gran problema 3: Técnica anti-scraping 一 ReCaptcha

Sin embargo, los problemas anteriores no son todos. Otro problema que puede encontrar durante el web scraping son los problemas de CAPTCHA

¿Qué es un CAPTCHA?

Con el fin de defenderse de los raspadores maliciosos que envían demasiadas solicitudes en un período de tiempo determinado y ponen presión en su servidor, algunos sitios web pueden requerir verificación humana

La idea de resolver Captchas es bastante simple: un cliente envía el Captcha al servidor. El servidor envía Captchas al agente que lo resuelve y luego envía la respuesta. Se tarda unos 10 segundos después de que se realizó la solicitud inicial, el cliente puede enviar una solicitud cada 5 segundos hasta que se resuelva.

Eleva la barra para la extracción de datos ya que CAPTCHA aparece en muchas formas y los scrapers generalmente no son lo suficientemente inteligentes como para ser aprobados prueba.

Tipos de CAPTCHA

- Imágenes gráficas, que deben decodificarse en texto.

- Código de verificación digital

(donde necesita hacer algunas operaciones y escribir respuesta, como 7 5 = ??) - Puzzle CAPTCHA

- CAPTCHA interactivo: reCaptcha, FunCaptcha, hCaptcha

Además, CAPTCHA evoluciona y genera otras variantes como reCAPTCHA v2 y reCaptcha v3 que se vuelven más difíciles de pasar.

¿Cómo solucionar el CAPTCHA?

- El propósito de CAPTCHA de verificación es regular y prevenir el tráfico en el sitio web. Es importante no sobrecargar el servidor demasiadas solicitudes en una ventana de tiempo determinada. Con un web scraping intuitivo como Octoparse, el problema se soluciona fácilmente imponiendo velocidad artificial.

- Octoparse también puede resolver algunos CAPTCHA simples, como los CAPTCHA del formulario de inicio de sesión.

- Hay muchos proveedores anti-CAPTCHA que pueden resolver CAPTHCA avanzados como un CAPTHCA de verificación digital o un CAPTCHA basado en imágenes.

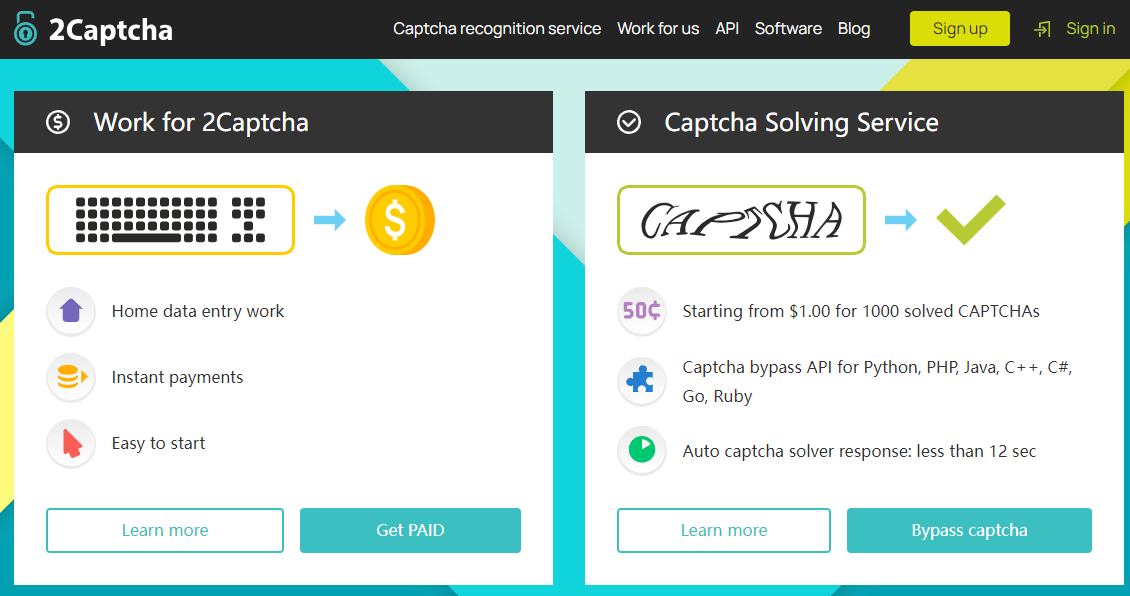

Tome 2Captcha como ejemplo. Sus servicios tienen algunas ventajas claras sobre otros en el mercado anti-captcha de hoy:

- Alta velocidad de resolución: 14 segundos para Captchas normales y 38 segundos para reCaptcha en promedio

- Alta tasa de precisión con hasta 99% (depende del tipo CAPTCHA).

Existen otros desafíos menores que le impedirían obtener datos de calidad de sitios web de comercio electrónico, como extraer datos de páginas consecutivas, editar XPath y limpiar datos. Pero no se preocupe, Octoparse está diseñado para que los no codificadores mantengan los dedos al tanto de las últimas noticias del mercado.

Conclusión

En general, superar estos retos es fundamental para el éxito de las empresas de comercio electrónico. Elegir una solución sólida de extracción de datos es clave para superar estos retos críticos. Utilizando una solución automatizada de extracción de datos, podrá gestionar fácilmente los datos procedentes de distintas fuentes. Integrar la solución con bases de datos, aplicaciones y otras herramientas de visualización puede ayudarle a tomar mejores decisiones con mayor rapidez.

Una vez superados los obstáculos iniciales en el proceso de extracción de datos, obtendrá una comprensión más completa de cómo los datos contribuyen a su negocio, mejorando en última instancia su viaje de datos empresariales y desarrollando una canalización de datos limpia que aporte valor.