Ninguna empresa puede sobrevivir sin datos. Sin embargo, la verdad es que estamos abrumados por los datos. Convertir los datos en información valiosa se mantiene en el valor central para que las empresas sigan creciendo. Business Intelligence se implementa a medida que convierte los datos sin procesar en información procesable. ¿Cómo funciona BI? Ilustraré con un ejemplo concreto de extracción de datos a interpretación de datos.

Pero antes de sumergirnos en él, necesitamos aclarar la diferencia entre los datos sin procesar y la información para tener una idea clara de por qué lo estamos haciendo.

Los datos sin procesar también se denominan datos primarios. Se recopila de una fuente que debe recopilarse para un análisis en profundidad. En los negocios, los datos pueden estar en cualquier lugar. Podría ser externo: datos que fluyen por la web como imágenes, publicaciones de Instagram, seguidores de Facebook, comentarios, seguidores de la competencia. O también podría ser interno: datos de un sistema de operación comercial como Content Management System (CMS).

La información se procesa y organiza datos que se presentan en forma de patrones y tendencias para una mejor toma de decisiones. Quisiera citar a Martin Doyle: “Las computadoras necesitan datos. Los humanos necesitan información. Los datos son un bloque de construcción. La información da sentido y contexto “.

Ahora que tiene una idea general del inicio y el final, vamos a desglosar la parte central en detalles.

Paso uno: Extracción de Datos

Este es un paso principal para hacer posible lo siguiente. Es un proceso de cero a uno en el que necesitamos comenzar a construir bloques. La extracción de datos es recuperar los datos de múltiples recursos en Internet. En esta etapa, todo el proceso tiene lugar en tres pasos:

1. Identifique la fuente: antes de comenzar la extracción, es necesario asegurarse de si la fuente es legal para extraer y la calidad de esos datos. Puede consultar los Términos de servicio (ToS) para obtener información detallada. Por ejemplo, todos sabemos que LinkedIn tiene toneladas de valores con respecto a las perspectivas de ventas. también Linkedin pensó eso. Así que no permiten ninguna forma de técnica de raspado para acceder a sus sitios web.

2. Iniciar extracción: una vez que tenga la fuente, puede comenzar la extracción. Hay muchas formas de extraer datos. El método principal en la actualidad es el web scraping. Una herramienta de raspado web automatizada es útil ya que elimina la necesidad de escribir scripts por su cuenta o contratar desarrolladores. Es la solución más sostenible y accesible para empresas con un presupuesto limitado y una gran demanda de datos.

Si menciono algunas de las mejores herramientas de web scraping, Octoparse se destaca como la herramienta de raspado web más intuitiva y fácil de usar, entre otras. Ofrece más de 30 plantillas de web scraping. Son rastreadores incorporados listos para usar sin ninguna configuración de tareas. Si no sabe codificar, le recomiendo que lo pruebe primero antes de pasar a la siguiente opción demasiado pronto.

Usemos un ejemplo rápido. Digamos que lanzo una campaña de video con un Influencer de Twitter. Necesito controlar el efecto de marketing. Examino Twitter, es legal raspar la información pública.

1. Abra Octoparse y navegue al “Modo de plantilla“

2. Busque la pestaña “Redes sociales” y haga clic en el icono “Twitter“.

3. Una vez que decida usar la plantilla, haga clic en “Usar plantilla” para continuar y escriba la palabra clave “Cheetos” en el cuadro de parámetros.

4. Luego haga clic en el botón “Guardar y ejecutar” para ejecutar su rastreador. Luego elija una “Extracción local“. “Extracción de la nube” es ejecutar el rastreador en la nube sin gravar el recurso local. Normalmente funciona en requisitos de datos a gran escala sin poner a prueba su computadora.

Aquí hay una salida de muestra, con Octoparse Twitter Scraping Template, raspé 5k líneas de datos que incluyen la ID de usuario, identificadores, contenidos, URL de video, URL de imagen. Una vez que obtenga los datos, puede enviarlos al formato deseado o conectarse a la plataforma de análisis como PowerBI o Tableau a través de API. No soy un experto en PowerBI, así que tomé prestado el Informe de Microsoft para hacer mi punto. La idea es que puede monitorear las redes sociales programando la extracción de Twitter (Instagram y Facebook) todos los días y conectarse a una plataforma de análisis preferida a través de API.

Paso Dos: Analizar

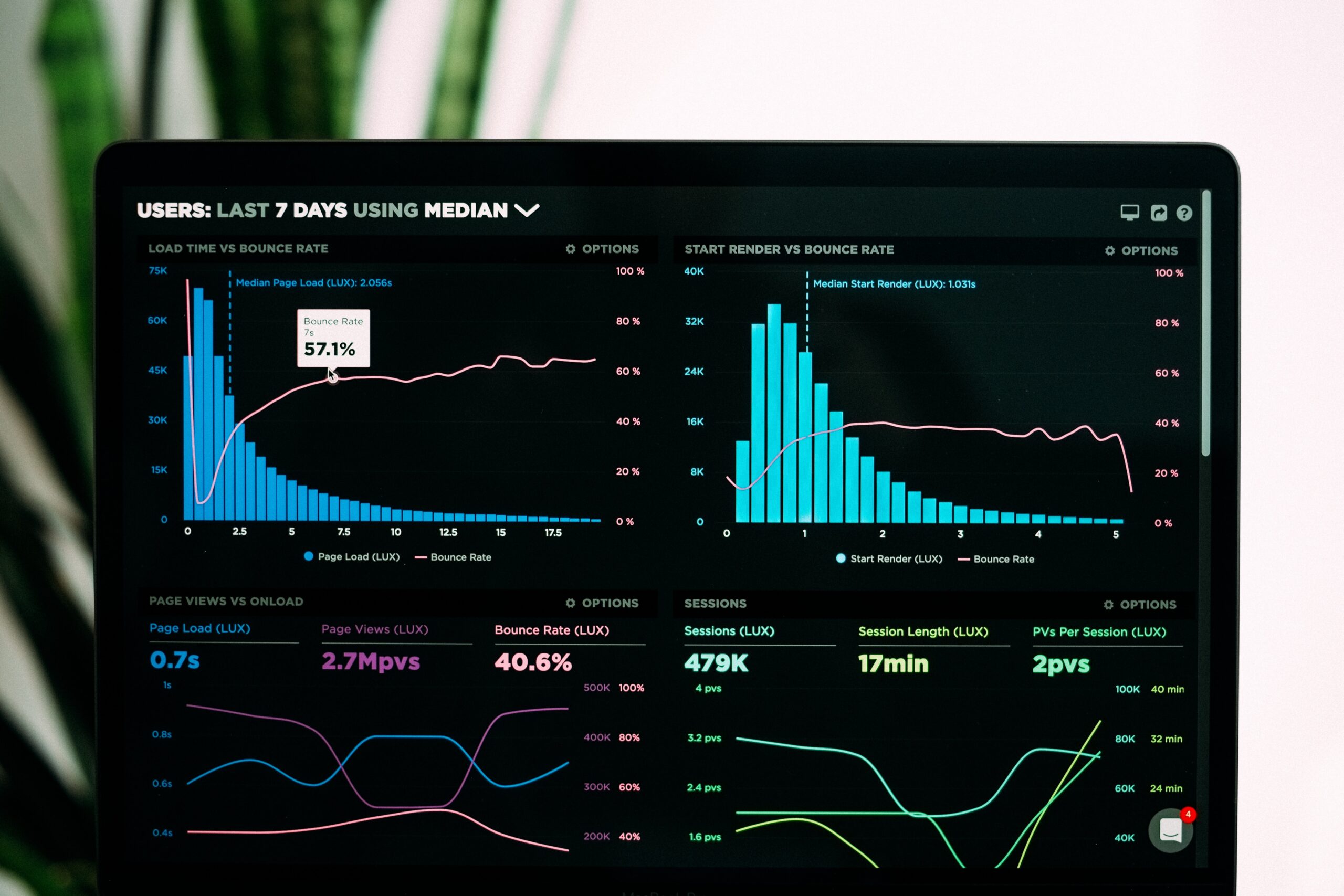

En la etapa de análisis, es necesario verificar la precisión ya que la calidad de los datos puede afectar el resultado del análisis directamente. En esta etapa, los datos se transmiten a los usuarios en varios formatos de informe, como visualizaciones y paneles. Usemos Power BI para monitorear y analizar plataformas de redes sociales para probar mi estrategia de marketing, la calidad del producto y la crisis de control.

Esta es una muestra de cómo usar POWER BI para presentar los datos en información.

Presente por @myersmiguel

O puede analizar qué publicación gana más Me gusta.

Bien, ahora tienes el tablero visual, ¿cómo puedes analizar?

En los negocios, la información debe interpretarse en relación con el contexto de la organización. Los antecedentes son una parte importante de la creación de ideas procesables.Tomemos Cheetos como ejemplo. Puede ver que la línea de tendencia de las menciones en abril es de 50k. La cantidad de Cheetos mencionados en Twitter gana 50k menciones en abril. Este es un número enorme, pero no revela ninguna información valiosa que no sea la cantidad mencionada en ese momento.

¿Qué sucede si saco todas las menciones de los meses anteriores y las comparo con las de este mes?

Abril: 50k menciona

Marzo: 40k menciona

Febrero: 1673 menciona

Ahora que proporcionamos el contexto, así es como interpreto la información:

Cheetos gana 10k menciones de marzo a abril.

Cheetos gana 38k menciones de febrero a marzo.

Podemos decir que Cheetos casi se hizo popular de la noche a la mañana. Y el marketing de boca en boca es exitoso. Para concluir, debemos continuar con esta estrategia y dejar que todos se sumerjan en Cheetos.

La idea es que los datos por sí mismos no tienen sentido. La mayoría de las empresas comparten tipos de datos similares pero varían en escalas. Sin embargo, la información que adquieren es diferente. El proceso de transformación incorpora el contexto de esa organización.

Por último, pero no menos importante: almacenamiento.

El almacenamiento de datos es el componente clave ya que las empresas confían en él para preservar los datos. El almacenamiento de datos varía en capacidad y nivel de velocidad. Con la profusión de big data, los proveedores de almacenamiento surgen y penetran en el mercado. Esta es una lista de proveedores confiables para su preferencia. Para herramientas de web scraping como Octoparse, proporciona un conjunto de funciones de extracción de datos de sitios web dinámicos, limpieza de datos con Regex incorporado, exportaciones de datos a formatos estructurados y almacenamiento en la nube. La mejor parte es que puede conectarse a su base de datos local con menos esfuerzo. No te ahogues en los datos, necesita un paseo con una herramienta inteligente.