En el campo comercial electrónico, se puede utilizar una gran cantidad de datos en plataformas online para el análisis empresarial. Por ejemplo, precios, stock, calificación, imágenes, etc. Estos datos ayudarán a los analistas y vendedores del mercado a evaluar el valor potencial o tomar decisiones más significativas.

Extraer por API

Algunos sitios web proporcionan API para que los usuarios accedan a parte de sus datos. Pero a pesar de que estos sitios proporcionan API, todavía existen algunos campos de datos que no pudimos scrape o no tenemos autenticación para acceder.

Por ejemplo, Amazon proporciona una API de publicidad de productos, pero la API en sí misma no podía proporcionar acceso a toda la información que se muestra en su página de productos para que la gente pueda scrape, como el precio, etc. En este caso, la única forma de scrape más datos, dicho campo de datos de precios, es construir nuestro propio scraper mediante programación o usar ciertos tipos de herramientas de scraper automatizadas.

Dificultades de la Recopilación de datos (también para programadores)

A veces, incluso si sabemos cómo scrapear los datos por nuestra cuenta mediante la programación, como usar Ruby o Python, aún no podríamos scrapear los datos con éxito por varias razones. En la mayoría de los casos, es probable que tengamos prohibido raspar de ciertos sitios web debido a nuestras acciones de scraping repetitivas sospechosas en muy poco tiempo. Si es así, es posible que necesitemos utilizar un proxy de IP que automatice la salida de las IP sin ser rastreados por esos sitios objetivo.

Las posibles soluciones descritas anteriormente pueden requerir que las personas estén familiarizadas con las habilidades de codificación y el conocimiento técnico más avanzado. De lo contrario, podría ser una tarea difícil o imposible de completar.

Herramientas de Web Scraper para Obtener Información Comercial

Para que el web scraping esté disponible para la mayoría de las personas, me gustaría enumerar varias herramientas de scrapear que pueden ayudarlo a raspar cualquier información comercial, incluidos precios, acciones, reseñas,etc., de manera estructurada con mayor eficiencia y velocidad mucho más rápida.

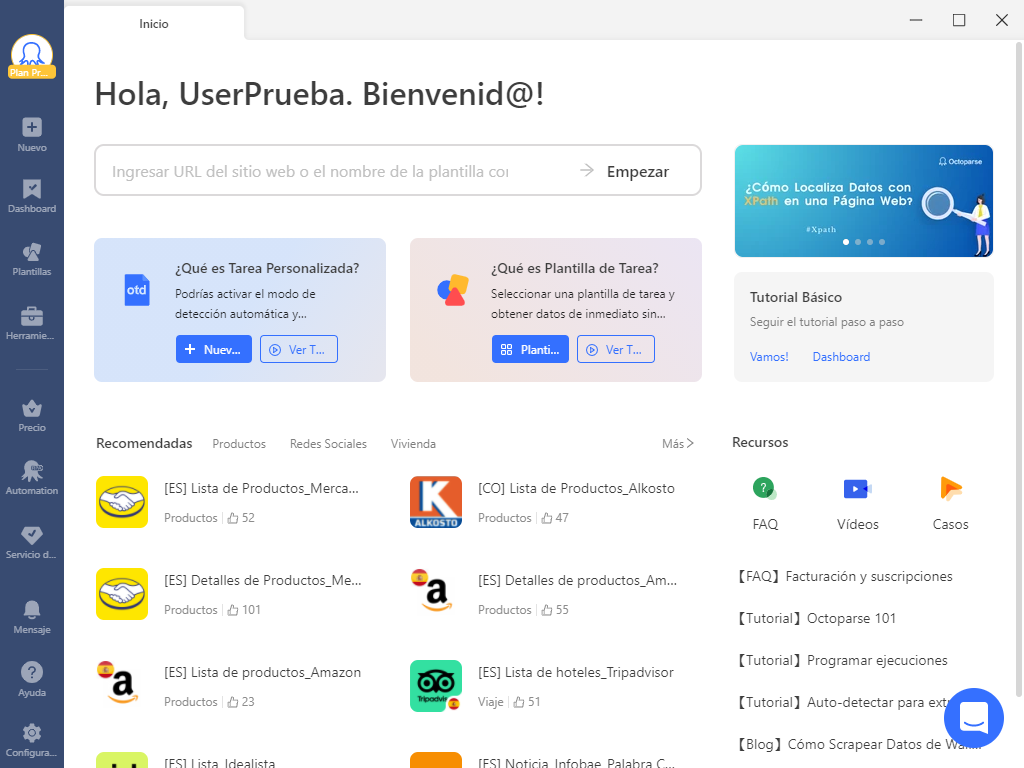

1. Octoparse

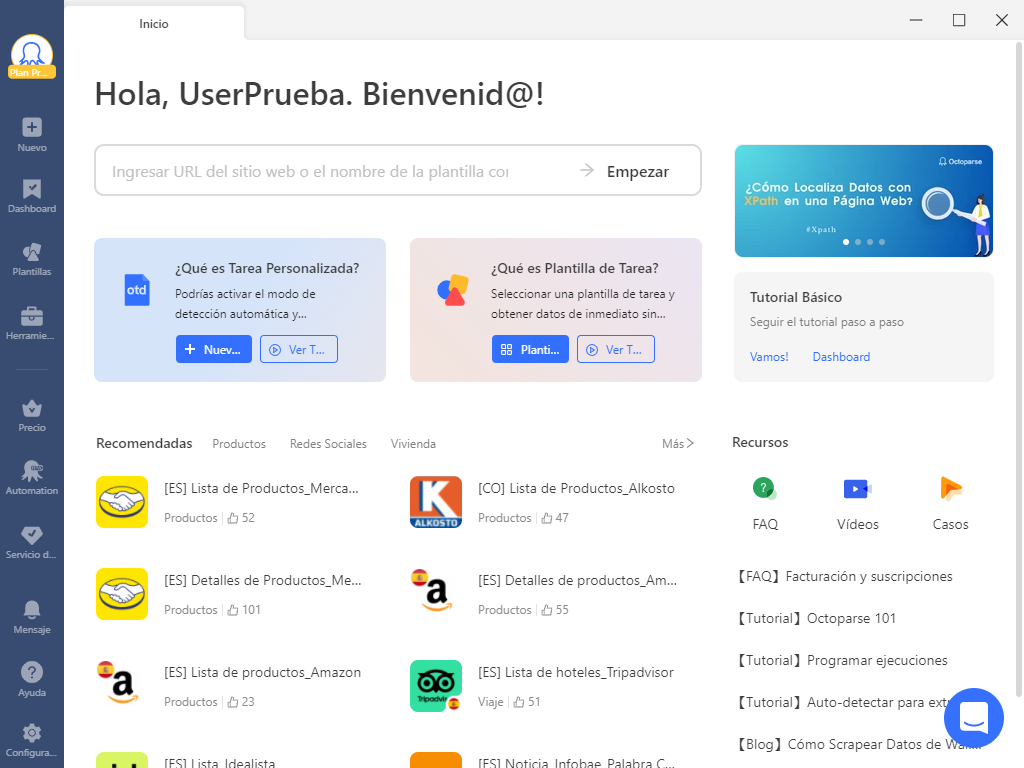

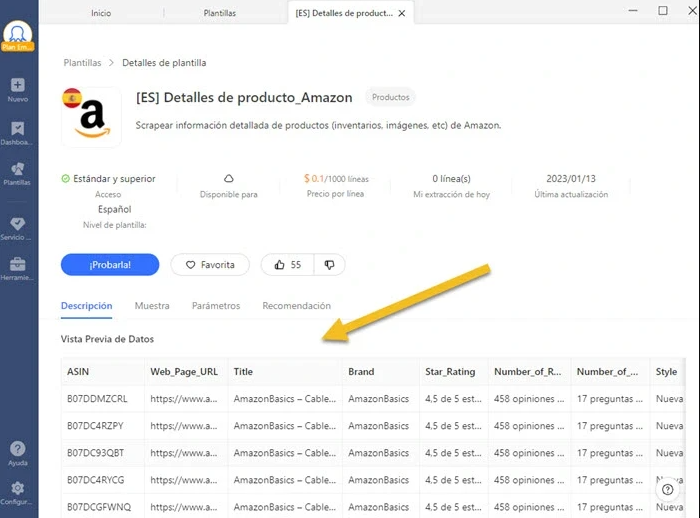

Puede usar esta herramienta de web scraping para raspar muchos sitios web, como Amazon, eBay, AliExpress, Mercado Libre, etc., para obtener datos que incluyen precios, comentarios, imágenes, URLs, etc. Los usuarios no necesitan saber cómo codificar para raspar datos ya que con solo hacer clics se puede crear un crawler personalizado.

La interfaz de usuario es fácil de usar, como se puede ver en la imagen a continuación. Hay un panel de Workflow donde puede hacer clic y arrastrar los campos de datos con acciones visuales. Simulando los comportamientos de navegación humana se raspan para los usuarios datos del comercio electrónico que luego se formatearán estructurados.

https://www.octoparse.es/template/mercadolibre-detalles-scraper

Con esta herramienta de extracción de datos, puede usar la IP de proxy solo configurando ciertas opciones o ingresando URL o palabras clave ya que Octoparse proporciona modo de Auto-Detectar y las plantillas prediseñadas, que en gran medida les facilitará a los usuarios el uso de este scraper. Así, puede descargar los datos, incluidos el precio, las revisiones, etc. en solo minutos, según lo necesite.

La extracción de cientos de datos se puede completar en segundos, incluidos tanto los de las páginas de listado como los de las páginas de detalles.

Como cada usuario tiene diferentes requisitos de datos y frecuencia de su exportación, Octoparse proporciona dos versiones de plan: plan gratuito y plan premium. Ambas cubren las necesidades básicas de raspado para los usuarios, lo que significa que los usuarios pueden raspar datos y exportar al menos 10,000 datos a formatos como CSV, Excel, HTML, TXT y bases de datos (MySQL, SQL Server y Oracle). Si bien, si desea obtener datos con una velocidad mucho más rápida, puede actualizar su cuenta gratuita a cualquier cuenta paga en la que esté disponible el servicio de la nube. Habrá al menos 6 servidores en la nube trabajando en sus tareas simultáneamente.

Además, Octoparse también ofrece servicio de datos y personalización de plantillas, lo que significa que puede expresar sus necesidades y requisitos de raspado y el equipo de soporte raspará por usted los datos que necesita.

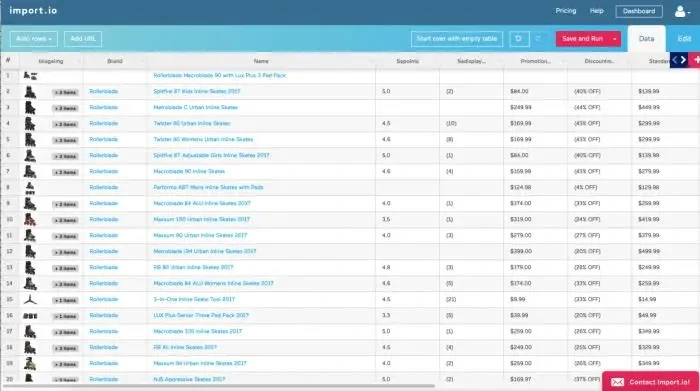

2. Import.io

Import.io también se conoce como un web crawler que cubre todos los diferentes niveles de necesidades de rastreo. Ofrece una herramienta mágica que puede convertir un sitio en una tabulación sin ninguna sesión de entrenamiento. Sugiere a los usuarios descargar su aplicación en el escritorio si es necesario rastrear sitios web más complicados.

Una vez que haya creado su API, ofrece una serie de opciones de integración simples, como Google Sheets, Plot.ly, Excel, así como solicitudes GET y POST. También proporciona servidores proxy para evitar que los usuarios sean detectados por los website de destino, y puede scrape tantos datos como necesite.

No es difícil usar esta herramienta por su interfaz de usuario simple. Puede consultar sus tutoriales oficiales para aprender cómo configurar sus propias tareas de scraping. Cuando considera que todo esto viene con una etiqueta de precio de por vida y un increíble equipo de soporte, import.io es un primer puerto claro para aquellos que buscan datos estructurados. También ofrecen una opción paga de nivel empresarial para empresas que buscan una extracción de datos más compleja o a gran escala.

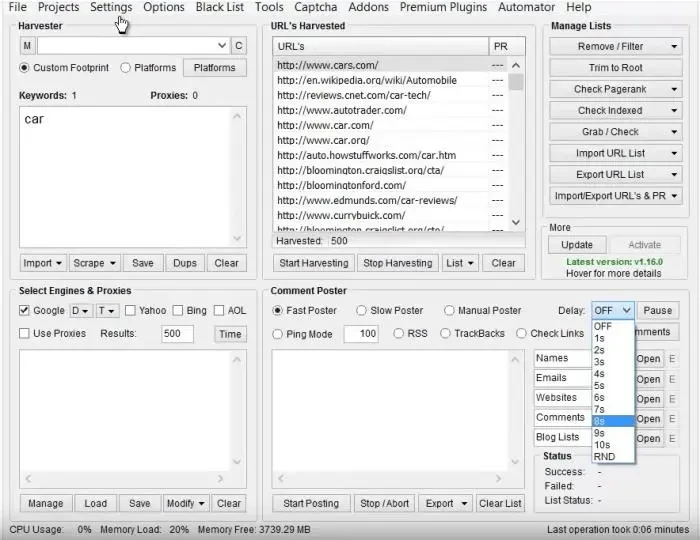

3. ScrapeBox

Los expertos en SEO, los vendedores en línea e incluso los spammers deberían estar muy familiarizados con ScrapeBox. Los usuarios pueden recolectar fácilmente datos de un website para recibir correos electrónicos, detectar el rango de la página y verificar los servidores proxy y el RSS submission. Mediante el uso de miles de servidores proxy rotativos, podrá escabullirse de las palabras clave del sitio de la competencia, investigar en sitios .gov, recopilar datos y comentar sin ser bloqueado o detectado.

Convetir datos de sitios web en Excel, CSV, Google Sheets y base de datos directamente.

Scrapear datos fácilmente con funciones de Auto-Detectar, sin codificación.

Plantillas de crawler preestablecidas para sitios web populares para obtener datos en clics.

Nunca se bloquee con proxies IP y API avanzada.

Servicio en la Nube para programar la recopilación de datos en cualquier momento que desee.