El web scraping es una de las tecnologías esenciales en el marketing digital moderno y el análisis de datos. Permite a los usuarios recopilar eficazmente grandes cantidades de datos publicados en Internet y utilizarlos para sus propias estrategias de marketing, análisis de la competencia e investigación de tendencias. Python, en particular, es popular tanto entre principiantes como entre usuarios avanzados debido a su sintaxis concisa y fácil de leer y a sus amplias bibliotecas.

Este artículo detalla los fundamentos del web scraping, cómo realizarlo realmente utilizando Python, así como ocho bibliotecas recomendadas. Al leerlo, podrás empezar a hacer web scraping sin problemas y recopilar datos de forma eficaz.

¿Qué es el Web Scraping?

El web scraping es una tecnología que recupera automáticamente datos de páginas web y extrae la información necesaria. Permite recopilar, analizar y almacenar eficazmente los datos publicados en Internet. Por ejemplo, el scraping puede utilizarse para obtener información en diversos formatos, como listas de precios de productos, artículos de noticias, reseñas, datos de publicaciones en SNS, etc.

Escenarios de uso del web scraping

El web scraping se utiliza en todo tipo de situaciones, incluidos los negocios y la investigación. A continuación, algunos ejemplos de los principales escenarios de uso

Marketing: se utiliza para rastrear las tendencias de precios de la competencia y analizar las opiniones de los consumidores recogidas en redes sociales y sitios de reseñas.

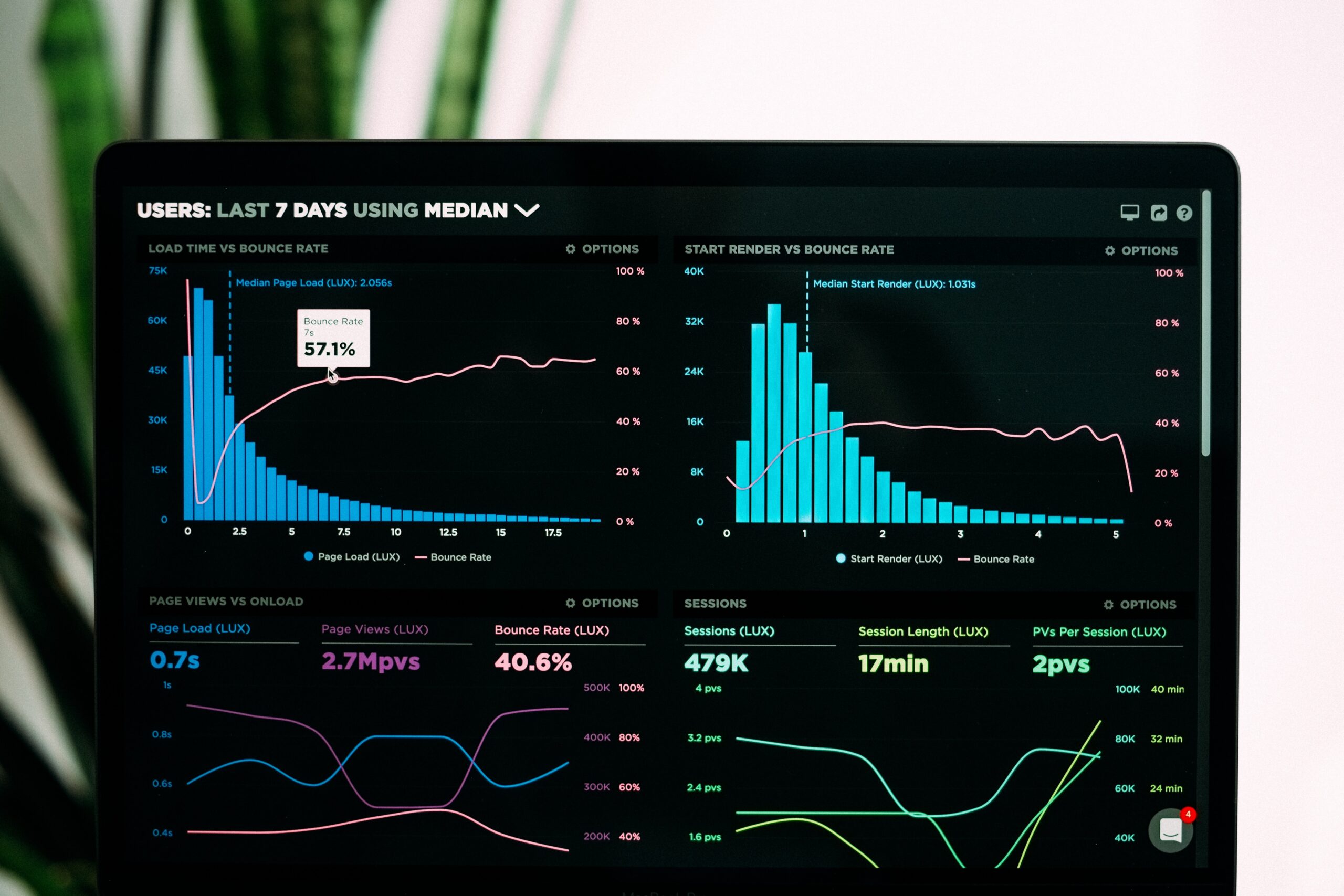

Análisis de datos: se utiliza para recopilar datos, noticias y cotizaciones bursátiles publicados por empresas para ayudar a tomar decisiones empresariales.

Investigación: como parte de la investigación académica, a veces se adquieren grandes conjuntos de datos que se utilizan para la investigación y el análisis.

Cómo funciona el web scraping

La mecánica del web scraping sigue los siguientes pasos

- Acceso a una página web: el programa accede a la URL especificada y obtiene los datos HTML de la página.

- Análisis de los datos HTML: el programa analiza los datos HTML recuperados y extrae los elementos especificados (por ejemplo, título, precio, enlaces, etc.).

- Guardar los datos: guarda los datos extraídos en un archivo CSV o en una base de datos para su uso posterior.

Puntos a tener en cuenta al realizar el web scraping

Al realizar el web scraping, hay que prestar atención a los riesgos legales y a los aspectos técnicos. He aquí algunos puntos con los que hay que tener especial cuidado.

Compruebe previamente las condiciones de uso y los derechos de autor del sitio web

Antes de realizar el scraping, es importante comprobar que no se infringen las condiciones de uso y los derechos de autor del sitio web de destino. Muchos sitios web prohíben la extracción de información, y extraer datos sin permiso puede dar lugar a actividades ilegales.

Respete las instrucciones de robots.txt.

Los sitios web utilizan el archivo robots.txt para restringir el acceso de los rastreadores. Al hacer scraping, se recomienda comprobar este archivo y dirigirse únicamente a las páginas cuyo acceso esté permitido.

Establezca el intervalo de solicitud adecuado

Establezca el intervalo de solicitud de raspado de forma adecuada para evitar sobrecargar el servidor web. Si el intervalo de acceso es demasiado corto, puede sobrecargar el servidor e impedir que otros usuarios accedan al sitio web.

Pasos para realizar web scraping

Las bibliotecas de Python se utilizan habitualmente para realizar web scraping en programación. Esta sección describe el procedimiento para el web scraping utilizando Python.

- Decidir qué sitios se van a raspar

En primer lugar, decida qué información va a obtener de qué sitios. Elija sus objetivos en función de los datos que desee adquirir, por ejemplo, noticias, sitios de comercio electrónico, sitios de redes sociales, etc. A la hora de hacer scraping, también es importante comprobar las condiciones de uso y las restricciones del sitio y asegurarse de que no se infringen.

- Instalar bibliotecas

Para realizar scraping en Python, es necesario instalar bibliotecas. En particular, ‘BeautifulSoup’, ‘Requests’ y ‘Scrapy’ son las más utilizadas. Para instalar, utilice el siguiente comando.

- Descargar el archivo HTML

A continuación, descargue el HTML de la página web de destino. Utilice el siguiente código para recuperar el contenido HTML de la URL especificada.

- Análisis del HTML

El HTML descargado se analiza utilizando ‘BeautifulSoup’. El siguiente código realiza el análisis y accede a los datos deseados.

- Extraer la información requerida

Extraiga la información requerida (por ejemplo, título, precio, etc.) del HTML analizado. A continuación se muestra un ejemplo de obtención de la etiqueta title.

- Guarde los datos extraídos

Por último, guarde los datos extraídos en un archivo. Utilice el siguiente código para escribirlos en un archivo de texto.

8 Bibliotecas Recomendadas para el Scraping con Python

Python dispone de una rica biblioteca para el scraping web eficiente. Aquí hay ocho bibliotecas típicas que son útiles para el scraping.

I. Beautiful Soup

Beautiful Soup es una biblioteca especializada en el análisis de datos HTML y XML. Tiene una sintaxis sencilla y se caracteriza por su fácil manejo para principiantes.

■ Ventajas

- Analiza y extrae HTML y XML utilizando una notación sencilla.

- Compatible con varios analizadores sintácticos (lxml, html.parser, html5lib, etc.).

- Fuerte manejo de errores y puede extraer datos de HTML defectuoso.

■ Desventajas

- No es compatible con el raspado dinámico de páginas con JavaScript

- No es adecuado para la recopilación de datos a gran escala

- Procesamiento relativamente lento

II. Scrapy

Scrapy es un framework y una librería de rastreo web en Python para recopilar datos de grandes sitios web de forma eficiente.

■ Ventajas

- Rápida recopilación de datos mediante procesamiento asíncrono

- Los datos pueden salir en formatos como JSON, CSV y XML.

- Se pueden gestionar tareas complejas como el seguimiento de enlaces y la paginación

■ Desventajas

- Costes de aprendizaje elevados para principiantes

- Dificultad para manejar páginas que contengan JavaScript dinámico

- Excesivamente específico para proyectos pequeños

III. Requests-HTML

Requests-HTML es una librería para recuperar fácilmente datos de páginas web y realizar análisis HTML; es una herramienta fácil de usar que combina los mejores aspectos de Requests y Beautiful Soup.

■ Ventajas

- API sencilla compatible con peticiones asíncronas y renderización JavaScript.

- Descarga, análisis y extracción en una sola biblioteca.

- Muy fácil de usar, adecuado para principiantes

■ Desventajas

- No dispone de funciones avanzadas de rastreo

- No es adecuado para la recopilación de datos a gran escala

- Pocos documentos

IV. Selenium

Selenium es una librería que manipula automáticamente el navegador para manipular páginas web, especialmente indicada para el scraping de páginas dinámicas con JavaScript.

■ Ventajas

- También se pueden adquirir datos de páginas generadas dinámicamente por JavaScript.

- Es compatible con una amplia gama de navegadores (Chrome, Firefox, etc.)

- Puede automatizar entradas de formularios complejos y operaciones de usuario

■ Desventajas

- El procesamiento es pesado y lento, ya que se manipula todo el navegador

- Requiere la configuración de bibliotecas

- No es adecuado para el scraping simple

V. Playwright

Playwright es una moderna librería de automatización de navegadores desarrollada por Microsoft que puede operar con múltiples navegadores y es similar a Selenium, pero más rápida y estable.

■ Ventajas

- Compatible con Chrome, Firefox y WebKit, con renderizado JavaScript.

- Rápido y capaz de procesamiento en paralelo

- También soporta capturas de pantalla, descargas de archivos, funciones de intercepción de red, etc.

■ Desventajas

- Curva de aprendizaje ligeramente superior

- Menos apoyo de la comunidad que Selenium

VI. PyQuery

PyQuery es una librería para el análisis sintáctico y la manipulación de HTML con una sencilla sensación similar a jQuery; permite manipular fácilmente estructuras HTML; es una potente herramienta para el desarrollo de aplicaciones HTML.

■ Ventajas

- HTML puede manipularse con una sencillez similar a jQuery

- HTML y XML pueden analizarse fácilmente

- Los datos pueden adquirirse utilizando selectores CSS.

■ Desventajas

- Menos usuarios e información limitada en comparación con Beautiful Soup

- No es adecuado para proyectos a gran escala

- No admite páginas dinámicas con JavaScript

VII. Lxml

Lxml es una biblioteca para el análisis rápido de XML y HTML con un rendimiento excelente. Es adecuada para el análisis de datos a gran escala.

■ Ventajas

- Análisis rápido y eficiente de HTML y XML.

- Posibilidad de vinculación con Beautiful Soup, lo que permite ampliar la funcionalidad.

- Interfaz sencilla, se pueden utilizar selectores XPath y CSS.

■ Desventajas

- La configuración inicial es complicada.

- Utiliza mucha memoria.

- Ligeramente sobre-especificado para proyectos pequeños.

VIII. Splash

Splash es un motor de renderizado que puede renderizar páginas web generadas con JavaScript y recuperar contenidos dinámicos.

■ Ventajas

- Renderiza JavaScript y permite la adquisición de datos de páginas web dinámicas

- Se ejecuta en un contenedor Docker y es fácil de configurar

- El scraping se puede ejecutar a través de la API

■ Desventajas

- Procesamiento más lento que el de otras bibliotecas

- No es adecuada para la recopilación de datos a gran escala

Soporte limitado

¿Cómo elegir la mejor biblioteca Python de scraping para su proyecto?

En un proyecto de web scraping, es muy importante elegir la biblioteca adecuada para el propósito y la escala del proyecto. Cada biblioteca tiene usos y beneficios especializados, y elegir la herramienta adecuada para los requisitos de su proyecto es la clave del éxito. En esta sección se explican los criterios de selección de una biblioteca en función del tipo de proyecto y sus necesidades.

Tamaño del proyecto

La biblioteca a utilizar depende del tamaño del proyecto. He aquí algunas bibliotecas adecuadas tanto para proyectos pequeños como grandes.

Proyectos a pequeña escala

Si el objetivo es la extracción sencilla de datos y el análisis HTML, Beautiful Soup y Requests son adecuadas. Estas bibliotecas son fáciles de configurar y ligeras, lo que las hace ideales para la recogida de pequeños volúmenes de datos y el análisis estructural de HTML. Proporcionan API fáciles de usar, incluso para principiantes.

Proyectos a media escala

Si necesita hacer scraping en varias páginas o procesar estructuras HTML complejas, Scrapy es la solución; Scrapy permite el procesamiento en paralelo y puede recopilar datos de sitios web de gran tamaño de forma eficaz.

Proyectos a gran escala

Si necesita recopilar grandes cantidades de datos de manera eficiente, o si necesita rastrear múltiples páginas para recopilar datos, Scrapy y Playwright son ideales. Estas bibliotecas admiten el procesamiento distribuido y asíncrono, lo que le permite trabajar con gran eficacia y reducir la carga de recursos.

Requiere contenido dinámico y compatibilidad con JavaScript

Algunas bibliotecas son adecuadas para páginas web dinámicas que utilizan JavaScript. Mediante el uso de estas bibliotecas, se puede automatizar el procesamiento de JavaScript y las operaciones del navegador.

Contenido dinámico que utiliza JavaScript

Selenium y Playwright son adecuadas para páginas web en las que el contenido se genera dinámicamente y se requiere el procesamiento de JavaScript. Estas bibliotecas pueden manipular automáticamente el navegador y recuperar el contenido exacto generado por JavaScript.

Inicio de sesión y gestión de formularios automatizados

Selenium y Playwright también son eficaces si un sitio web requiere autenticación de inicio de sesión o necesita manipular formularios para la introducción de datos por parte del usuario. Estas herramientas emulan la interacción humana en el navegador y automatizan operaciones del usuario como rellenar formularios y hacer clic.

Cuando importa la velocidad de procesamiento y el rendimiento

Las bibliotecas que admiten el procesamiento asíncrono o paralelo son adecuadas cuando es necesario recopilar grandes cantidades de datos a gran velocidad o cuando se requiere un procesamiento eficaz.

Recogida rápida de grandes volúmenes de datos

Scrapy y HTTPX, que destacan en el procesamiento asíncrono, son ideales para la recopilación rápida de datos de grandes sitios web. Estas bibliotecas procesan múltiples peticiones en paralelo, lo que hace que la adquisición de datos sea mucho más eficiente.

Procesamiento de peticiones ligero y sencillo

Para peticiones HTTP sencillas y adquisición de datos a pequeña escala, Requests es la mejor opción. Esta biblioteca ligera y sencilla elimina las funciones innecesarias, lo que hace que su procesamiento sea ligero y adecuado para proyectos orientados al rendimiento.

Si quieres empezar a hacer web scraping fácilmente, te recomendamos que utilices una herramienta de scraping.

No es necesario tener conocimientos de programación para realizar el web scraping. Utilizando una herramienta de scraping, incluso los principiantes pueden extraer datos fácilmente.

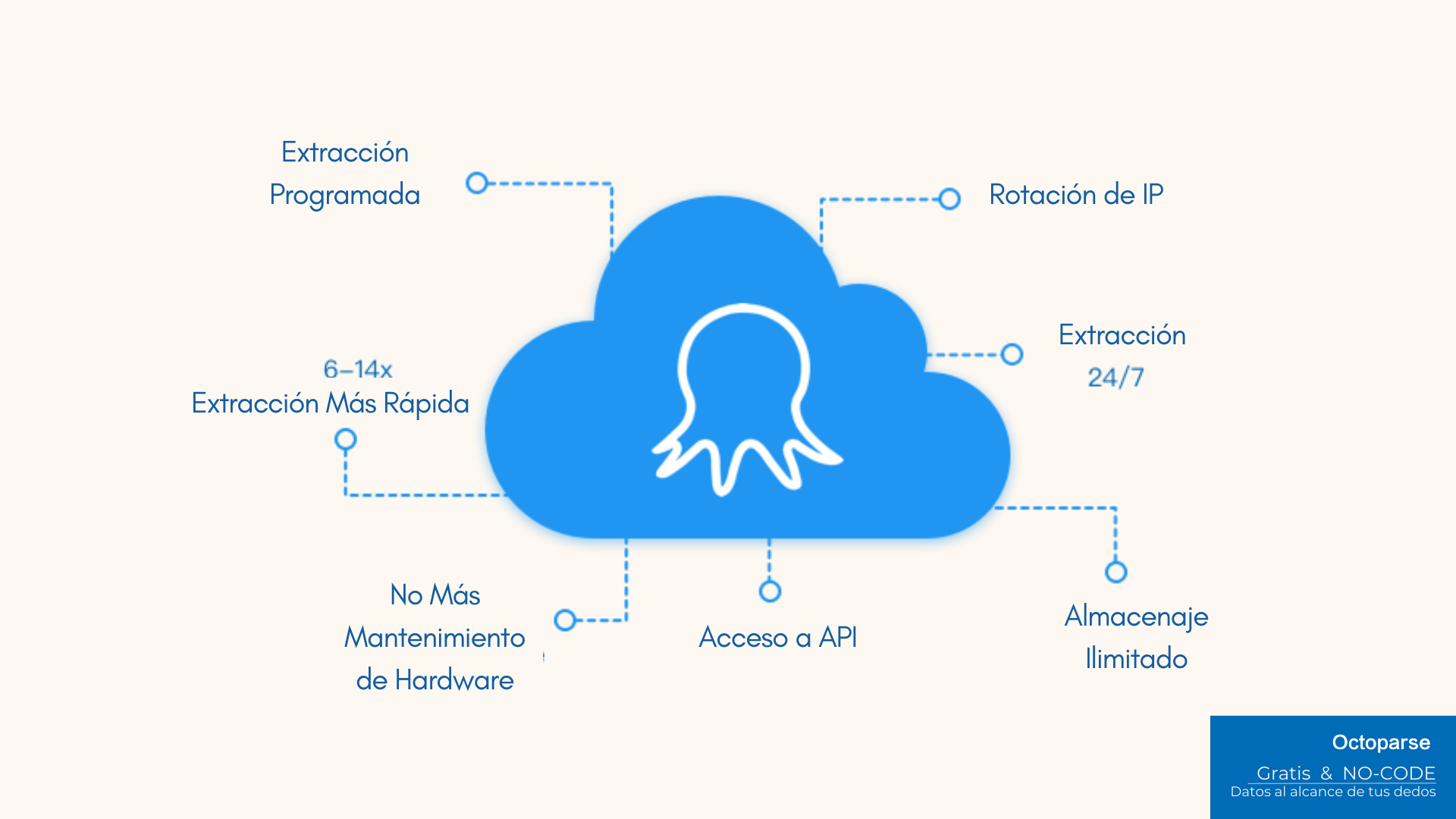

En esta sección se explican las herramientas de scraping y se presenta una especialmente recomendada, Octoparse.

¿Qué son las herramientas de web scraping?

Una herramienta de scraping es una herramienta que permite realizar el scraping web a través de una interfaz visual sin necesidad de escribir código. Tienen las siguientes características

- Interfaz visual: basada en GUI, por lo que se puede configurar fácilmente arrastrando y soltando.

- Configurable sin código: la extracción de datos es posible sin conocimientos de programación.

- Multifuncionales y escalables: muchos de ellos también incluyen funciones avanzadas como la automatización de datos, la ejecución programada y el procesamiento dinámico de contenidos.

Características de Octoparse

Octoparse es una de las soluciones más populares entre las numerosas herramientas de scraping. Fácil de usar y lo suficientemente versátil para principiantes, Octoparse tiene las siguientes características:

- Fácil de usar, sin necesidad de código: el funcionamiento basado en GUI y la configuración intuitiva de scraping facilitan que cualquiera pueda recuperar datos.

- Compatibilidad con contenidos dinámicos: los datos pueden extraerse de contenidos dinámicos generados por JavaScript y de sitios que requieren inicio de sesión.

- Automatización y programación: la extracción de datos se puede programar y realizar de forma periódica, de modo que las actualizaciones diarias se pueden recopilar automáticamente.

Por otro lado, Octoparse puede no ser adecuado para la recopilación avanzada de datos. Para una recogida de datos más compleja y de gran volumen, se recomienda el scraping con Python.

- Limitado para configuraciones complejas: la personalización detallada y los grandes proyectos pueden requerir un scraping basado en código.

- Requiere una versión de pago: el plan gratuito tiene una funcionalidad limitada y requiere una actualización a una versión de pago para una funcionalidad completa.

Resumen

Este artículo ha detallado los fundamentos del web scraping, pasos específicos en Python, y cómo elegir las mejores bibliotecas para su proyecto Python es uno de los mejores lenguajes para el scraping, con su sintaxis simple y amplias bibliotecas.

Por otro lado, lleva tiempo y esfuerzo para un novato en programación aprender Python desde cero. Si quieres hacer scraping fácilmente, puedes utilizar Octoparse, una herramienta de scraping que se puede utilizar sin necesidad de código, para extraer datos fácilmente. Adopte el método más adecuado en función de la finalidad de la adquisición de datos y la escala de la operación.

Convetir datos de sitios web en Excel, CSV, Google Sheets y base de datos directamente.

Scrapear datos fácilmente con funciones de Auto-Detectar, sin codificación.

Plantillas de crawler preestablecidas para sitios web populares para obtener datos en clics.

Nunca se bloquee con proxies IP y API avanzada.

Servicio en la Nube para programar la recopilación de datos en cualquier momento que desee.