El web crawling o el raspado de datos web se está volviendo cada vez más popular en los últimos años. Los datos scraping se pueden usar para varios análisis, incluso predicciones. Al analizar los datos, las personas pueden obtener información sobre una industria y enfrentarse a otros competidores. Aquí, podemos ver cuán útil y necesario es obtener datos de alta calidad a una velocidad más rápida y a gran escala. Además, la mayor demanda de datos ha impulsado el rápido crecimiento del servicio Web Crawler.

Servicio de Web Scraper (Rastreador Web)

Web Crawler Service(Servicio de raspados web) se puede encontrar fácilmente si lo busca a través de Google. Más exactamente, es un tipo de servicio pago personalizado. Cada vez que desee rastrear un sitio web o cualquier conjunto de datos, deben pagar al proveedor del servicio. Luego puede obtener los datos scraped que desea. Hay algo que debe notar, debe tener cuidado con el proveedor de servicios que elija y expresar sus requisitos de datos de la manera más clara y exclusiva posible.

Propondré algunos servicios de rastreo web (web crawler) que he usado o aprendido para su referencia. De todos modos, la evaluación de los servicios es difícil ya que esos servicios evolucionan continuamente para servir mejor al cliente. La mejor manera de decidir es cuáles son sus requisitos y lo que se ofrece, mapearlos y clasificarlos usted mismo.

Proveedores de servicios de datos Recomendados

1. DataHen

DataHen es conocido como un proveedor profesional de servicios de rastreadores web (web crawlers). Ha ofrecido un servicio integral y paciente, que abarca todos los niveles de rastreo de datos o requisitos de raspado de personal, nuevas empresas y empresas. No necesitará comprar o aprender un software de raspado utilizando DataHen. Cuando algunos sitios que requieren autenticación los bloquean, pueden completar formularios. La interfaz de usuario es fácil de entender, como se puede ver a continuación, solo necesita completar la información requerida y le entregarán los datos que necesita rastrear.

2. Grepsr

Grepsr es una potente plataforma de servicio de rastreo (crawler) que proporciona múltiples tipos de necesidades de rastreo de datos de usuario. Para comunicarse mejor con los usuarios, Grepsr ha proporcionado requisitos bastante claros e integrales que recopilan la interfaz de usuario como se muestra a continuación. También hay tres ediciones del Plan de pago de Grepsr, desde Starters hasta Enterprises. Los usuarios pueden elegir cualquier plan en función de sus respectivas necesidades de rastreo.

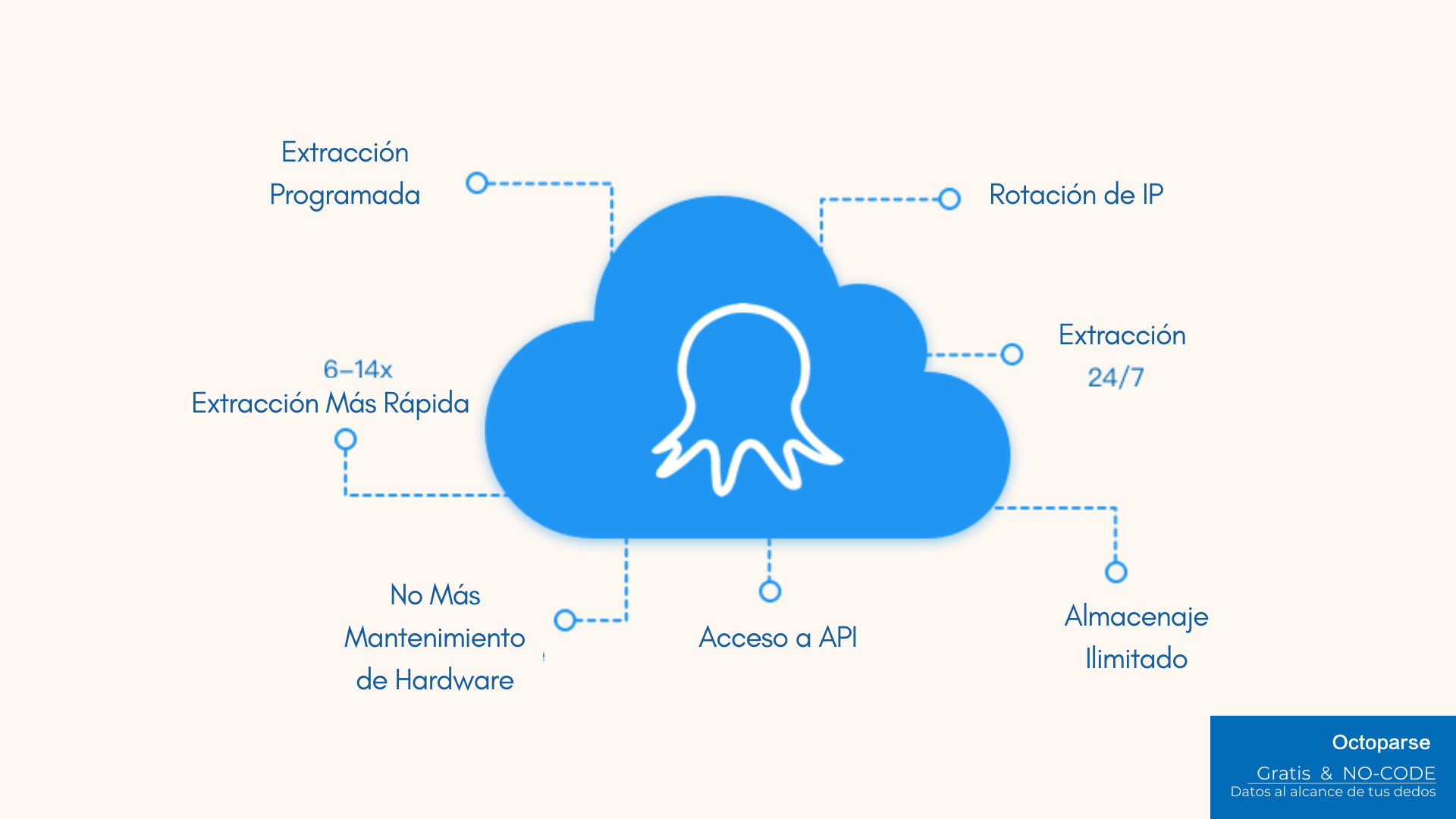

3. Octoparse

Octoparse debe definirse como una herramienta de raspado web (web scraping), aunque también ofrece un servicio personalizado de rastreadores de datos. Servicio de Octoparse Web Crawler también es poderoso. Las tareas se pueden programar para que se ejecuten en la plataforma en la nube, que incluye al menos 6 servidores en la nube que trabajan simultáneamente. También es compatible con las rotaciones de IP, lo que evita que ciertos sitios web lo bloqueen. Además, la API de Octoparse permite a los usuarios conectar su sistema a sus datos raspados en tiempo real. Los usuarios pueden importar los datos de Octoparse en su propia base de datos o utilizar la API para exigir el acceso a los datos de su cuenta.

Además, Octoparse ofrece un Plan de extracción de edición gratuita. La edición gratuita también puede satisfacer las necesidades básicas de raspado o rastreo de los usuarios. Cualquiera puede usarlo para raspar o rastrear datos después de registrar una cuenta. Lo único es que necesita aprender a configurar las reglas básicas de raspado para rastrear los datos que necesita, de todos modos, es fácil comprender las habilidades de configuración. La interfaz de usuario es clara y fácil de entender, como se puede ver en la figura a continuación. Por cierto, su servicio de respaldo es profesional, los usuarios con cualquier duda pueden contactarlos directamente y obtener comentarios y soluciones lo antes posible.

Convetir datos de sitios web en Excel, CSV, Google Sheets y base de datos directamente.

Scrapear datos fácilmente con funciones de Auto-Detectar, sin codificación.

Plantillas de crawler preestablecidas para sitios web populares para obtener datos en clics.

Nunca se bloquee con proxies IP y API avanzada.

Servicio en la Nube para programar la recopilación de datos en cualquier momento que desee.